Wie KI deine digitalen Assets endlich durchsuchbar macht

Warum klassische DAMs an Grenzen stossen

Digitale Asset Management Systeme wurden eigentlich entwickelt, um Ordnung ins Medienchaos zu bringen. In der Praxis scheitern sie jedoch häufig an einem simplen Problem: Wenn ein Bild ohne gute Beschreibung abgelegt wird, bleibt es für immer unsichtbar. Über Jahre entstehen so grosse Sammlungen schlecht gelabelter, teils doppelter und oft unstrukturierter Bilder.

Und selbst wenn viel Zeit in die Datenpflege investiert wird, bleibt die Suche mühsam. Es sind zwar unzählige Bilder vorhanden, aber es ist schwer genau das Bild zu finden, welches man gerade im Kopf hat.

Ein Beispiel:

Gesucht wird ein Bild von einem Stausee in einer Berglandschaft im Winter. Gespeichert wurde das Bild aber mit dem Label «Bergsee umgeben von verschneiten Bergen». Die Folge: Der Suchbegriff passt nicht und das Bild bleibt unauffindbar.

Die Lösung: Semantische Suche dank Computer Vision

Mit modernen KI-Modellen lässt sich dieser Prozess umdrehen. Das Zauberwort dafür heisst Computer Vision, ein Teilgebiet der künstlichen Intelligenz. Die KI-Modelle werden so trainiert, dass sie Bilder und Videos ähnlich wie Menschen „sehen“ und interpretieren können. Statt hohen Aufwand und manueller Pflege während der Ablage, analysiert ein KI-Modell jedes Bild automatisch und wandelt es in eine mathematische Repräsentation (Vektor) um. Dieser Vektor beinhaltet die Information, was auf dem Bild enthalten ist: Objekte, Szenen, Stimmungen. Dabei kann ein Modell nicht nur unabhängige Elemente auf einem Bild erkennen, sondern auch den Kontext verstehen, wie diese Elemente miteinander zusammenhängen.

Das Resultat:

Unstrukturierte Bilder werden automatisch indexiert und können mit beliebigen Suchbegriffen durchsucht werden – ganz ohne manuelles Tagging.

Der Vorteil:

Die initiale Analyse dauert zwar etwas Zeit, doch danach lassen sich selbst hunderttausende Bilder innert Millisekunden durchsuchen.

Wie funktioniert das technisch?

Aber wie soll ein KI-Modell komplexe Inhalte von einem Bild erfassen können?

Moderne Modelle wie CLIP oder Perception Encoder basieren auf multimodalen Transformern. Sie werden mit Milliarden Bild-Text-Paaren trainiert und lernen so, wie visuelle Inhalte und Wörter zusammenhängen. Dabei werden die Bild- und Text-Transformer so trainiert, dass sie aus semantisch ähnlichen Bilder und Texten möglichst ähnliche Vektoren berechnen.

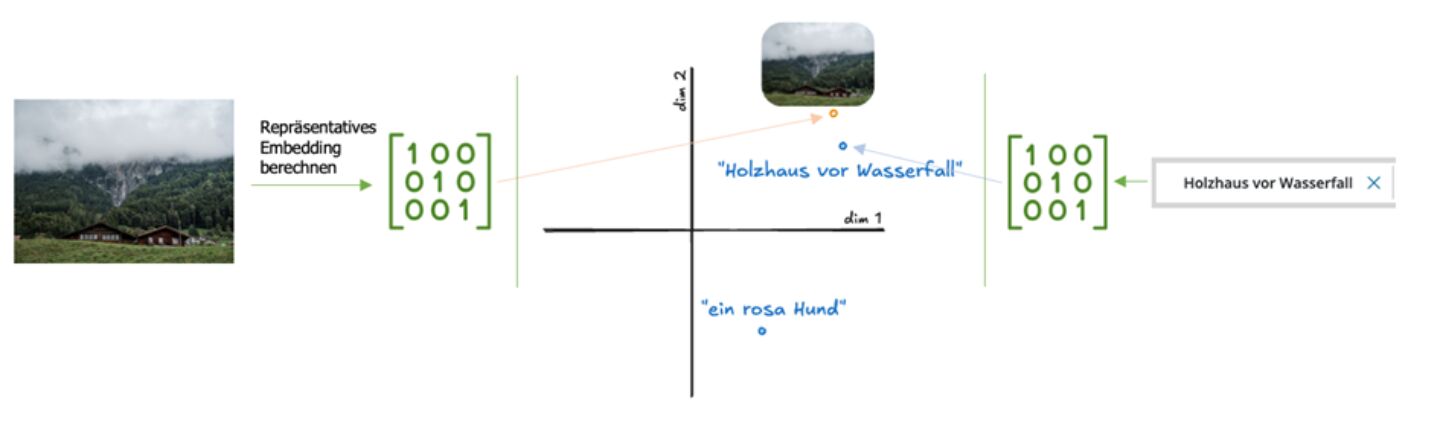

Diese Vektoren beinhalten je nach Grösse des Modells zwischen 512 und 1240 Zahlen. Der einfachheitshalber kann man aber die Idee dahinter in einem zweidimensionalen Raum visualisieren. Im Bild unten ist ersichtlich, dass die Distanz zwischen Bilder und Texte mit ähnlichen semantische Informationen ganz klein ist.

Der Ablauf:

- Alle Bilder werden in Embeddings umgewandelt.

Das Modell erkennt Objekte, Farben, Formen, Szenen und implizite Kontexte.

- Die Embeddings werden in einer Vektor-Datenbank gespeichert.

Diese ermöglicht ultraschnelle Ähnlichkeitssuchen.

- Ein Suchbegriff wird ebenfalls in ein Embedding umgewandelt.

Z.b. der Suchbegriff („Stausee in den Bergen im Winter“) wird ebenfalls in ein Embedding verwandelt.

- Beide Vektoren werden verglichen.

Je kleiner die Distanz, desto besser passt das Bild zum Suchbegriff.

So entsteht eine semantische Suche, die nicht auf exakten Begriffen basiert, sondern auf inhaltlicher Bedeutung.

Vorteile für Unternehmen

Durch die automatische Analyse von Bildern ergeben sich klare Mehrwerte:

- Semantische Suche statt Keyword-Suche

Suchanfragen wie «Herbstlandschaft» oder «Menschen am Arbeiten» funktionieren, auch wenn niemand diese Begriffe je manuell erfasst hat.

- Kein manuelles Tagging mehr

Die KI übernimmt die Arbeit. Und wenn neue Modelle erscheinen, können alle Bestandsbilder erneut – und noch besser – verarbeitet werden.

- Ähnliche Bilder finden

Die Embeddings eignen sich auch für Ähnlichkeitssuchen oder den Upload von Referenzbildern.

- Extrem schnell, extrem skalierbar

Auch über 100’000 Bilder lassen sich in Millisekunden durchsuchen.

- Funktioniert auf bestehenden Ablagen

Egal wie chaotisch und unstrukturiert die Bilder und Videos bisher abgelegt wurden, die KI analysiert die Dateien einmalig und macht sie durchsuchbar

Typische Anwendungsfälle

Wir unterstützen dich gerne bei deinen Herausforderungen, unabhängig vom System, das du heute nutzt.

- Filesystem mit unzähligen Medien

Kein DAM? Kein Problem. KI macht das Rohmaterial direkt durchsuchbar.

- Erweiterung eines bestehenden DAM

Wir ergänzen dein System um KI-Suche, Re-Indexierung und Integrationen.

- Beratung bei DAM-Auswahl

Technologie, Architektur, Integration: Wir helfen bei der Entscheidungsfindung.

Ist das etwas für euch?

Sind Fotos oder Videos ein wichtiges Asset deiner Organisation?

Verliert ihr viel Zeit bei der Suche nach dem passenden Visual?

Gab es schon Situationen, in denen ein Motiv doppelt produziert wurde?

Dann lass uns sprechen. Wir helfen dir, Ordnung in deine Archive zu bringen – effizient, sicher und zukunftssicher.

Weitere Themenbeiträge

Rückblick auf die Swiss {ai} Weeks in Bern – eine Woche voller Austausch und Innovation

Die Swiss {ai} Weeks in Bern haben gezeigt, dass auch die Hauptstadtregion starke Impulse im Bereich Künstliche Intelligenz setzt. BEGASOFT eröffnete die Woche mit dem Event AI in Action, präsentierte …

lesenIdentity & Access Management: Schlüsselrolle im digitalen Ökosystem

Identity & Access Management ist das Rückgrat jedes digitalen Ökosystems. Keycloak bietet eine offene, unabhängige und zukunftssichere Lösung, die bereits von Organisationen wie CERN, dem EU-Parlament …

lesenSwiss {ai} Weeks 2025: Sichere KI gemeinsam erleben, challengen und entwickeln

Die Swiss {ai} Weeks 2025 sind mehr als ein Event – sie sind ein Ort, an dem wir KI gemeinsam mit Kunden, Partnern und der Community erleben, challengen und weiterentwickeln. Mit unserer Plattform Bra …

lesen